Cuatro argumentos que cambian tu forma de pensar sobre esos gastos.

Si estás en tus treinta y tantos, probablemente seas como yo, y deberías recordar la vieja época de este mundo donde cada servicio en línea era gratuito. Vivíamos en un mundo donde la piratería era una situación normal. Todo, desde películas hasta música, desde libros hasta software era gratis. Podías encontrar rápidamente un torrent, un enlace de descarga directa, o incluso si eres más viejo, un enlace de Mule. ¿Todavía recuerdas Mule? Jaja, sí, yo también.

Nuestra generación se alejó de una era de «todo gratis sin la mejor calidad» a un enfoque de «pago por servicio». Y esta transición está siendo complicada. Así que, si ese es tu caso o conoces a alguien que usualmente tiene este tipo de pensamiento, intentaré explicar por qué deberías preocuparte menos por el costo de esos servicios.

1. No estamos evaluando esos gastos de la misma manera que lo hacemos con los servicios físicos

Ese es el primer tema, y me gustaría explicarlo un poco más. Imagina la suscripción a Medium, si no me equivoco, son 50€ al año por acceso ilimitado a esos artículos, y conozco a mucha gente que piensa que es caro, que no vale lo que ofrecen.

Las mismas personas pueden gastar 50€ al mes en una suscripción al gimnasio y no piensan que esto sea caro en absoluto. Así que, ahora, probablemente estés pensando algo como esto: ¡Vamos! ¡No eres justo! ¿Cómo te atreves a comparar la suscripción a Medium con una suscripción al gimnasio?

El gimnasio tiene una infraestructura física que necesitan mantener. Tienen personas trabajando allí, en la recepción, servicios de limpieza, entrenadores personales, etc. También tienen costos adicionales debido al uso de la infraestructura como electricidad, agua, impuestos, etc.

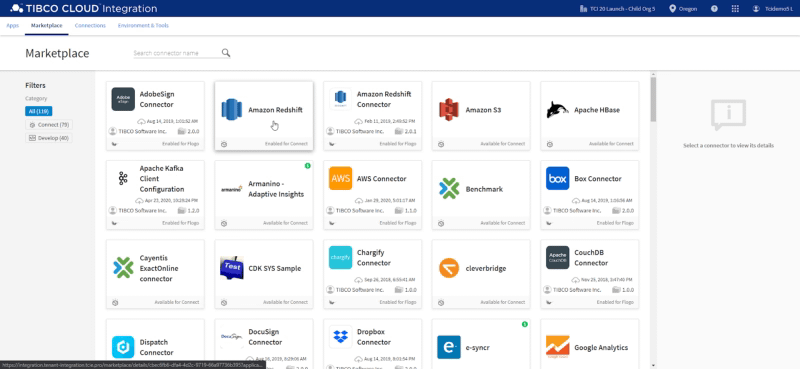

¡Sí, eso es cierto! ¿Y qué hay de Medium? ¿No tiene la misma situación? Tienen una infraestructura en la nube que necesitan mantener, servidores, red, almacenamiento, copias de seguridad, etc. También tienen personas trabajando en ello: en el sitio mismo, curadores, pero también desarrolladores, administradores de sistemas, etc., para realizar todas las tareas de mantenimiento para mantener el lugar al mejor nivel posible para que lo uses. Así que, esto no es diferente en absoluto en ambos casos. Pero este no es el único argumento.

2. ¡Los servicios en línea son increíblemente más baratos!

Ahora, en lugar de hablar de Medium, hablemos de una aplicación que podrías pensar que es cara. Hablemos de Netflix, que dependiendo de tu país puede tener una tarifa mensual de unos 15–20€.

Y puedes argumentar, pero no veo ni el 0.1% de su catálogo, ¿por qué debería pagar por todo si no voy a usar todo lo que ofrece?

Pero piensa en cuánto te costaron las entradas de cine la última vez que pudiste salir (Sí, sí, lo sé, este no es el mejor momento para hablar de cines y salir en esta situación, pero aguanta conmigo en esta).

Hagamos las cuentas conmigo: Dos personas yendo al cine, 10 € cada uno por las entradas. Si tienes algo más para beber o comer, podrías rápidamente gastar 35 € solo por una sesión de 2 horas.

Por supuesto, incluso con el mejor sistema de cine en casa, no es comparable en absoluto con lo que puedes sentir en una sesión de cine, pero ese no es el tema. El argumento es que si puedes permitirte una sesión de cine al mes (Sí, solo una al mes) y no sientes que estás desperdiciando tu dinero, puedes permitirte Netflix + Disney + Prime Video al mismo ritmo.

Y esto se aplica a todo. Siempre recomiendo cuando hablo de esto con otras personas comparar con algo físico que hacen sin pensarlo mucho, por ejemplo, un café matutino. Muchos de nosotros tomamos una taza de café para llevar cada día de nuestra vida laboral. Imagina un costo promedio de 1.5€, y cada mes tiene 20 días laborables, eso significa que estás gastando 30 € al mes solo en tu café matutino. Una vez más, la misma cantidad para tres servicios de streaming de video de primera.

La idea principal de este argumento no es que dejes de tomar esa primera taza de café que necesitas para que tu cuerpo funcione y se prepare para el día. Aún así, piensa que si no sientes mucho por ese café matutino, no deberías preocuparte tanto por la tarifa del servicio en línea también.

3. Puedes reevaluar tu decisión en cualquier momento

Además, otro argumento para no preocuparse mucho por esto es porque puedes revisarlo cada vez que quieras. El procedimiento aquí no es el mismo que usas para evaluar la compra de tu nuevo iPad, o si necesitas una laptop o un coche. Que necesitas estar muy seguro de que vas a sacarle el máximo provecho.

En este caso, esta es una tarifa recurrente que puedes cancelar en cualquier momento si crees que no la vas a usar o ves que no es tan útil como pensabas. Así que, no hay problema en probarlo por unos meses, y si no funciona, simplemente cancélalo. Así que, si tienes ese poder y opciones en tus manos, ¿por qué estás tan preocupado por dar ese paso de pagar por primera vez solo para probar?

Lo hacemos todo el tiempo en otros aspectos de la vida. Imagina la siguiente situación en el mercado, cuando ves una nueva marca de algo que vas a comprar. Puede ser yogur fresco, jugo fresco, o incluso una nueva cerveza. ¿Cuántas veces obtienes algo de una nueva marca, solo para probar? ¡Probablemente la respuesta sea TODO EL TIEMPO! Y sí, estás pagando por ello, no es como si fueras al cajero y le dijeras: No, no, déjame solo probar esto por varios meses y probablemente el próximo año pueda ver si vale la pena.

4. Estamos invirtiendo en nosotros mismos

Este argumento puede parecer extraño al principio porque parece más: No, no, no. Estoy invirtiendo en esta empresa, sus desarrolladores, y puedo sentirme feliz por ello, pero esto es una transacción. Sí, eso también es cierto, pero imagina eso. ¿Qué te pasa si todos los servicios que estás usando en línea desaparecen porque ya no es un negocio sustancial para ellos? ¿Va a afectar tu vida? Sí, seguro.

Solo recuerdo la primera aplicación que usé mucho que fue descontinuada y eliminada. Siempre he sido un chico de Linux, y he usado mucho una herramienta de gestión de tareas llamada BasKet como parte del entorno KDE que era similar a lo que hoy es OneNote. Podías juntar muchos tipos de contenido y gestionarlo como quisieras.

Era increíble, pero finalmente decidieron dejar de trabajar en la herramienta, y la herramienta no fue actualizada, y sí, eliminaron la herramienta. Mi vida cambió mucho. Necesitaba encontrar otra herramienta para hacer el mismo trabajo e imagina qué: No había ninguna en ese momento (estaba hablando de 2006 🙂 ). Así que mi vida fue peor porque nadie apoyó su esfuerzo al nivel que necesitaban para seguir haciéndolo. Así que, también deberías pensar eso, ¿cuánto me costará si esta aplicación X desaparece?

Conclusión

Así que, espero que estos argumentos puedan ayudarte a cambiar de opinión o ser útiles en tus conversaciones con otras personas que tienen esta idea de que todo debería ser gratis en el mundo en línea para ser más coherentes con la realidad en la que vivimos ahora. Así que, probemos nuevos servicios en línea, ¡y probablemente descubramos que nuestra vida en línea puede ser mejor!